A menudo, en clases, talleres o seminarios sobre investigación educativa, participo en interesantes diálogos sobre causalidad. Estos diálogos giran alrededor de cuándo se puede establecer con rigor académico que una variable A (típicamente un programa educativo) causa, es decir genera, un impacto sobre una variable B (resultados en pruebas de aprendizaje, tasas de repetición o deserción u otros). A menudo la respuesta es que la evidencia disponible no permite establecer causalidad, pues no se puede descartar que lo que exista entre A y B sea solamente una asociación, es decir una correlación estadística positiva.

Un ejemplo de una aparente relación de causalidad que es solamente una asociación entre variables viene de la vida cotidiana: a menudo las personas piensan que jugar básquet causa que las personas sean más altas. La evidencia parece incontrastable: los jugadores de básquet son en promedio bastante más altos que la población; por lo tanto, se dice, jugar básquet resulta en que las personas crezcan más. Sin embargo, sin negar los efectos positivos del ejercicio en el desarrollo físico en general, lo que ocurre en este caso es que los entrenadores de básquet, conociendo la importancia de la talla en el juego, suelen elegir a los más altos para su equipo, aún si les tienen que enseñar habilidades básicas. Como dice un amigo entrenador: “a una persona alta le puedo enseñar a jugar, pero a una baja no le puedo enseñar a crecer”. Otro ejemplo de la vida cotidiana es que la gente suele pensar que arrancarse una cana genera que crezcan dos, sin considerar que lo que genera el avance de las canas es un proceso de desarrollo natural, vinculado a factores de la persona que no tienen que ver con cuántas canas se arranca.

El diseño de investigación que se suele considerar más adecuado para establecer relaciones de causalidad es el experimental. En este diseño, se asignan aleatoriamente (al azar) un número grande[1] de unidades (personas, salones de clase, instituciones educativas, etc.) a un grupo de tratamiento o al grupo de control. La asignación aleatoria funciona porque al usar alguna forma de sorteo para definir quiénes van a cada grupo se hacen equivalentes estadísticamente. Así, cualquier diferencia entre los grupos luego del tratamiento y control puede atribuirse, con un cierto grado de confianza definido estadísticamente, al tratamiento. Es lo que se ha hecho en los estudios recientes sobre las vacunas contra el COVID: aleatoriamente se define quiénes recibirán el tratamiento y quiénes un placebo; estos últimos forman el grupo de control.

En el caso educativo el diseño experimental tiene también el mayor respaldo entre los académicos para establecer relaciones de causalidad; sin embargo, hay notables diferencias con la forma en que se implementa en el campo médico. Para empezar, no es posible implementar algo parecido a un placebo (ausencia de tratamiento): no sería ético dejar completamente sin educación a un grupo (el de control). Así, típicamente se compara un tratamiento (por ejemplo, una intervención educativa novedosa, usando tecnología, acompañando a docentes, mejorando la nutrición de los estudiantes, etc.) con la forma tradicional de educación (sin tratamiento), que funciona como grupo de control. La pregunta que se suele querer contestar es, ¿qué beneficios adicionales proporciona este tratamiento por encima de la forma tradicional de implementar la educación?

En el Perú, a menudo se ha afirmado la efectividad de algunos programas educativos sin contar con un diseño de evaluación apropiado. Por ejemplo, hace unos años se afirmó que un programa de alfabetización para adultos era eficaz porque más del 90% de evaluados había aprobado una prueba de lectura y escritura al final del curso. Sin embargo, leyendo el informe, se observó que el diseño de evaluación no incluía un grupo de control, tampoco una evaluación inicial de las habilidades de los participantes, y solo se evaluó a aquellos que habían completado el curso completo de alfabetización (es decir, no se evaluó a los que dejaron de asistir a lo largo del curso).

Otro caso de aparente causalidad es que se suele decir que la educación privada es mejor que la pública porque sus estudiantes logran mejores resultados en pruebas estandarizadas, al menos en la educación secundaria (en la primaria los resultados son mixtos). En realidad, no se puede comparar directamente la eficacia de la educación privada versus la pública sin considerar la composición socioeconómica de los estudiantes que asisten a unas versus otras. Como se sabe, los estudiantes que asisten a escuelas privadas tienen mayores recursos que los segundos, lo cual les permite pagar una mensualidad como pensión. Se sabe también que el nivel socioeconómico se asocia positivamente con el rendimiento educativo. Así, sin controlar por la variable características socioeconómicas de los estudiantes, es difícil afirmar que una es “mejor” que la otra. Por razones obvias, sería difícil realizar un experimento como se ha descrito antes para analizar este tema. Por lo demás, afirmar que un tipo de educación es mejor o peor que otra solo con base en resultados en pruebas, típicamente de lectura y matemática, solo estaría atendiendo a una dimensión de múltiples posibles como resultado de una buena educación; por ejemplo, se podrían incluir mediciones sobre habilidades socioemocionales, desarrollo físico, conducta ciudadana, etc.

El diseño experimental no está exento de críticas. Los resultados educativos son el resultado de la confluencia de una serie de factores, que incluyen la calidad del tratamiento (intervención educativa), las características de docentes y estudiantes (por ejemplo, etnicidad), los recursos disponibles (pedagógicos y financieros), la calidad en la implementación del programa y el apoyo de la comunidad al programa educativo, entre otros. Cuando se hace una intervención se tiene que considerar que es difícil que un tratamiento, que consiste usualmente en una intervención pedagógica puntual, pueda generar un cambio masivo (o, como se suele decir en investigación, estadísticamente significativo), por lo que en muchos casos no se encuentran cambios en las variables de resultados. Además, los estudios experimentales solo consideran algunas variables de resultado a la vez (típicamente resultados en pruebas de habilidades). Por esto, los resultados de evaluaciones experimentales, siendo muy valiosos, deben considerarse como parte de la evidencia disponible para juzgar el mérito de cualquier intervención.

Existen por supuesto alternativas para evaluar el mérito de una intervención educativa. La principal es una evaluación cualitativa. Este tipo de evaluaciones considera el conjunto de factores que pueden afectar la implementación y resultados de la evaluación. Los métodos consisten usualmente en observaciones, entrevistas, análisis de documentos y otros registros, y grupos focales, en los que se reconoce la subjetividad de los participantes y del propio investigador/a. Estas evaluaciones también tienen gran valor para entender el valor de un programa educativo, pero no se habla al usarlas de impacto, pues como se mencionó antes, se reserva este término para estudios que usan diseños experimentales o similares, donde se puede establecer que A causa B; es más, a menudo los estudios cualitativos no requieren un grupo de control ni pruebas u otros instrumentos estandarizados, pues se triangula información reportada por diferentes actores y registros.

Como conclusión de lo anterior, para entender el mérito de algún programa o política educativa es necesario analizar con detenimiento el diseño de investigación utilizado, para poder entender qué es lo que se puede afirmar a partir de la evidencia existente. Lamentablemente, con excepciones, no contamos con estudios experimentales ni cualitativos rigurosos sobre los programas educativos, por lo que se terminan iniciando o cerrando programas sin evidencia sólida. Es urgente generar evidencia de calidad con diseños rigurosos, que permita afinar programas existentes, descontinuar los que no han funcionado o ampliar los que funcionan bien en pequeña escala.

[1] Mientras más grande el número de unidades, mayor el poder estadístico para identificar efectos estadísticos; en diseños experimentales se suele contar al menos con 60 unidades, la mitad de las cuales va al grupo de tratamiento y el resto al grupo de control.

A menudo, en clases, talleres o seminarios sobre investigación educativa, participo en interesantes diálogos sobre causalidad. Estos diálogos giran alrededor de cuándo se puede establecer con rigor académico que una variable A (típicamente un programa educativo) causa, es decir genera, un impacto sobre una variable B (resultados en pruebas de aprendizaje, tasas de repetición o deserción u otros). A menudo la respuesta es que la evidencia disponible no permite establecer causalidad, pues no se puede descartar que lo que exista entre A y B sea solamente una asociación, es decir una correlación estadística positiva.

Un ejemplo de una aparente relación de causalidad que es solamente una asociación entre variables viene de la vida cotidiana: a menudo las personas piensan que jugar básquet causa que las personas sean más altas. La evidencia parece incontrastable: los jugadores de básquet son en promedio bastante más altos que la población; por lo tanto, se dice, jugar básquet resulta en que las personas crezcan más. Sin embargo, sin negar los efectos positivos del ejercicio en el desarrollo físico en general, lo que ocurre en este caso es que los entrenadores de básquet, conociendo la importancia de la talla en el juego, suelen elegir a los más altos para su equipo, aún si les tienen que enseñar habilidades básicas. Como dice un amigo entrenador: “a una persona alta le puedo enseñar a jugar, pero a una baja no le puedo enseñar a crecer”. Otro ejemplo de la vida cotidiana es que la gente suele pensar que arrancarse una cana genera que crezcan dos, sin considerar que lo que genera el avance de las canas es un proceso de desarrollo natural, vinculado a factores de la persona que no tienen que ver con cuántas canas se arranca.

El diseño de investigación que se suele considerar más adecuado para establecer relaciones de causalidad es el experimental. En este diseño, se asignan aleatoriamente (al azar) un número grande[1] de unidades (personas, salones de clase, instituciones educativas, etc.) a un grupo de tratamiento o al grupo de control. La asignación aleatoria funciona porque al usar alguna forma de sorteo para definir quiénes van a cada grupo se hacen equivalentes estadísticamente. Así, cualquier diferencia entre los grupos luego del tratamiento y control puede atribuirse, con un cierto grado de confianza definido estadísticamente, al tratamiento. Es lo que se ha hecho en los estudios recientes sobre las vacunas contra el COVID: aleatoriamente se define quiénes recibirán el tratamiento y quiénes un placebo; estos últimos forman el grupo de control.

En el caso educativo el diseño experimental tiene también el mayor respaldo entre los académicos para establecer relaciones de causalidad; sin embargo, hay notables diferencias con la forma en que se implementa en el campo médico. Para empezar, no es posible implementar algo parecido a un placebo (ausencia de tratamiento): no sería ético dejar completamente sin educación a un grupo (el de control). Así, típicamente se compara un tratamiento (por ejemplo, una intervención educativa novedosa, usando tecnología, acompañando a docentes, mejorando la nutrición de los estudiantes, etc.) con la forma tradicional de educación (sin tratamiento), que funciona como grupo de control. La pregunta que se suele querer contestar es, ¿qué beneficios adicionales proporciona este tratamiento por encima de la forma tradicional de implementar la educación?

En el Perú, a menudo se ha afirmado la efectividad de algunos programas educativos sin contar con un diseño de evaluación apropiado. Por ejemplo, hace unos años se afirmó que un programa de alfabetización para adultos era eficaz porque más del 90% de evaluados había aprobado una prueba de lectura y escritura al final del curso. Sin embargo, leyendo el informe, se observó que el diseño de evaluación no incluía un grupo de control, tampoco una evaluación inicial de las habilidades de los participantes, y solo se evaluó a aquellos que habían completado el curso completo de alfabetización (es decir, no se evaluó a los que dejaron de asistir a lo largo del curso).

Otro caso de aparente causalidad es que se suele decir que la educación privada es mejor que la pública porque sus estudiantes logran mejores resultados en pruebas estandarizadas, al menos en la educación secundaria (en la primaria los resultados son mixtos). En realidad, no se puede comparar directamente la eficacia de la educación privada versus la pública sin considerar la composición socioeconómica de los estudiantes que asisten a unas versus otras. Como se sabe, los estudiantes que asisten a escuelas privadas tienen mayores recursos que los segundos, lo cual les permite pagar una mensualidad como pensión. Se sabe también que el nivel socioeconómico se asocia positivamente con el rendimiento educativo. Así, sin controlar por la variable características socioeconómicas de los estudiantes, es difícil afirmar que una es “mejor” que la otra. Por razones obvias, sería difícil realizar un experimento como se ha descrito antes para analizar este tema. Por lo demás, afirmar que un tipo de educación es mejor o peor que otra solo con base en resultados en pruebas, típicamente de lectura y matemática, solo estaría atendiendo a una dimensión de múltiples posibles como resultado de una buena educación; por ejemplo, se podrían incluir mediciones sobre habilidades socioemocionales, desarrollo físico, conducta ciudadana, etc.

El diseño experimental no está exento de críticas. Los resultados educativos son el resultado de la confluencia de una serie de factores, que incluyen la calidad del tratamiento (intervención educativa), las características de docentes y estudiantes (por ejemplo, etnicidad), los recursos disponibles (pedagógicos y financieros), la calidad en la implementación del programa y el apoyo de la comunidad al programa educativo, entre otros. Cuando se hace una intervención se tiene que considerar que es difícil que un tratamiento, que consiste usualmente en una intervención pedagógica puntual, pueda generar un cambio masivo (o, como se suele decir en investigación, estadísticamente significativo), por lo que en muchos casos no se encuentran cambios en las variables de resultados. Además, los estudios experimentales solo consideran algunas variables de resultado a la vez (típicamente resultados en pruebas de habilidades). Por esto, los resultados de evaluaciones experimentales, siendo muy valiosos, deben considerarse como parte de la evidencia disponible para juzgar el mérito de cualquier intervención.

Existen por supuesto alternativas para evaluar el mérito de una intervención educativa. La principal es una evaluación cualitativa. Este tipo de evaluaciones considera el conjunto de factores que pueden afectar la implementación y resultados de la evaluación. Los métodos consisten usualmente en observaciones, entrevistas, análisis de documentos y otros registros, y grupos focales, en los que se reconoce la subjetividad de los participantes y del propio investigador/a. Estas evaluaciones también tienen gran valor para entender el valor de un programa educativo, pero no se habla al usarlas de impacto, pues como se mencionó antes, se reserva este término para estudios que usan diseños experimentales o similares, donde se puede establecer que A causa B; es más, a menudo los estudios cualitativos no requieren un grupo de control ni pruebas u otros instrumentos estandarizados, pues se triangula información reportada por diferentes actores y registros.

Como conclusión de lo anterior, para entender el mérito de algún programa o política educativa es necesario analizar con detenimiento el diseño de investigación utilizado, para poder entender qué es lo que se puede afirmar a partir de la evidencia existente. Lamentablemente, con excepciones, no contamos con estudios experimentales ni cualitativos rigurosos sobre los programas educativos, por lo que se terminan iniciando o cerrando programas sin evidencia sólida. Es urgente generar evidencia de calidad con diseños rigurosos, que permita afinar programas existentes, descontinuar los que no han funcionado o ampliar los que funcionan bien en pequeña escala.

[1] Mientras más grande el número de unidades, mayor el poder estadístico para identificar efectos estadísticos; en diseños experimentales se suele contar al menos con 60 unidades, la mitad de las cuales va al grupo de tratamiento y el resto al grupo de control.

Comentarios: 0

Comentarios: 0

Valoraciones: 1

Valoraciones: 1

Desde Educared, queremos compartir a las familias una guía muy útil elaborada por el Ministerio de Educación en alian ...

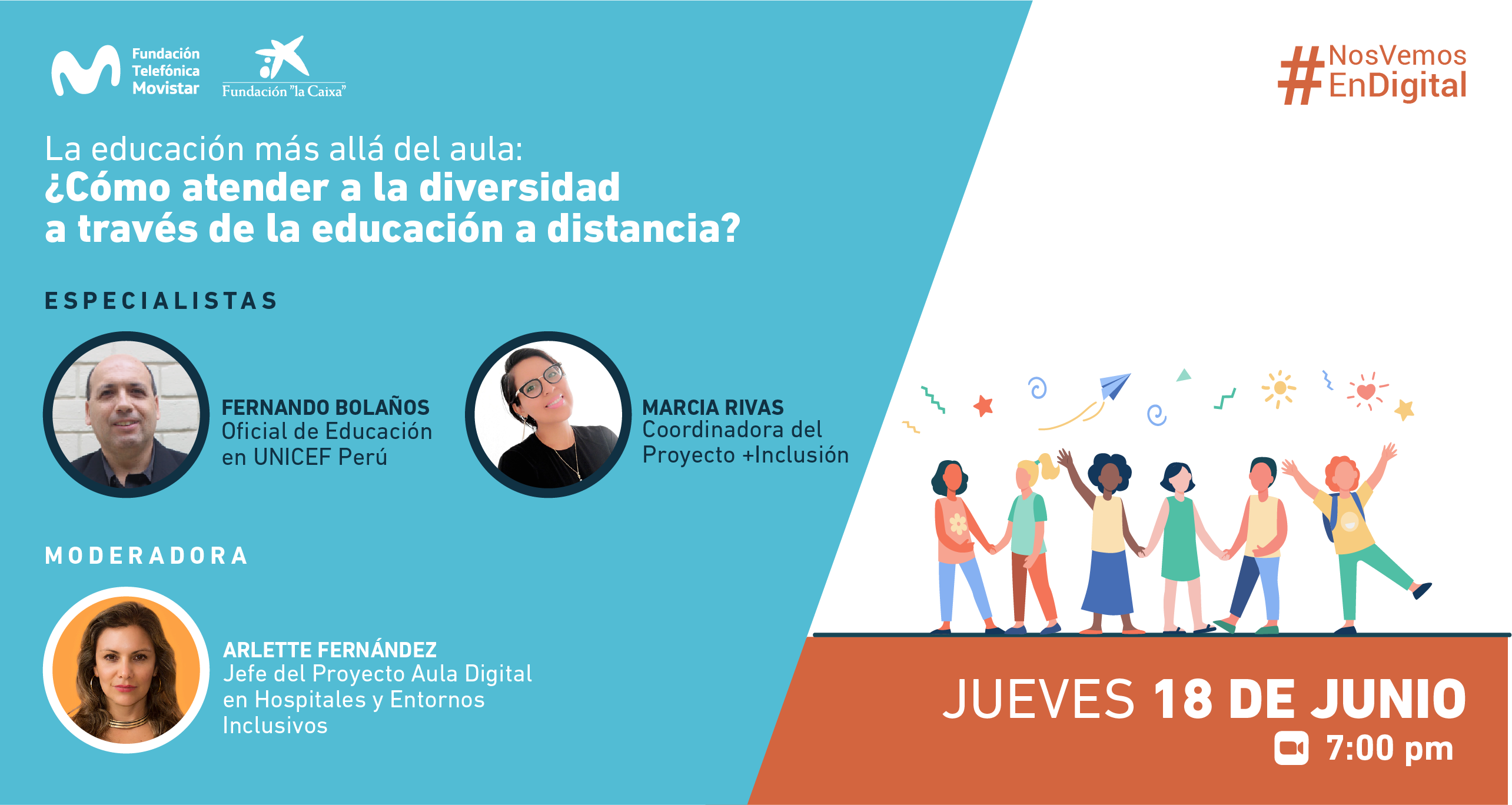

Educación más allá del aula es un conjunto de conversatorios online organizado por Fundación Telefónica y Educared ...

A través de Fundación Telefónica/Movistar y “la Caixa” Foundation se ha puesto a disposición del Ministerio de E ...

Escribe un comentario

Debe Registrarse o Iniciar sesión para publicar un comentario.